前言

2025 年的 AI 市场正在发生剧变。

如果你关注 AI 模型的更新,你会看到这样的进展:

- Claude 系列:从 Claude 3 升级到 Opus 4.1(推理能力 +40%)、Sonnet 4.5(性价比之王)、Claude Haiku 4.5(新生代模型强势登场,特别优化了多语言和编码能力)

- DeepSeek R1/V3:持续优化,成为中国企业的首选

- Amazon Nova:自研模型矩阵进一步完善,成本优势继续扩大

但这些技术进步背后的真实故事是:企业 AI 的游戏规则已经彻底改变了。

曾经,企业 AI 是关于”有没有钱投入 ¥300 万去部署私有化大模型”。

现在,它关乎”如何用最合适的模型和架构,以最低的成本快速解决实际业务问题”。

基于我在 2025 年最新的 AI 实践总结,我为你揭示 5 个关键洞察,以及更新的成本数据和应用案例。

洞察 1:从”硬件军备竞赛”到”应用架构优化”的转变

曾经的困境

还记得我们之前讨论的私有化部署吗?那时候,企业面临的最大挑战是:

- 671B FP16 满血版需要 ¥193 万的 H20 配置

- 年度运维成本 ≥¥100 万

- 总投资超过 ¥300 万,而且还未必能解决实际问题

这种模式下,只有大企业才能玩得起企业级 AI。

转折点

但现在情况正在改变:

| 时间 | 变化 | 意义 |

|---|---|---|

| 2024年末 | DeepSeek R1/V3 上线 | 性价比大幅提升 |

| 2025年初 | AWS Bedrock + DeepSeek R1 | Serverless 推理成本下降 50% |

| 2025年中 | Amazon Nova(自研模型) | 成本进一步优化,满足中小企业 |

| 现在(2025年10月) | AI Agent 编排框架成熟 | 应用层创新成为主要价值 |

关键转变:从关注”用什么模型、多少参数”转向”用什么架构、怎么降成本、如何真正产生业务价值”

实战启示

我们的做法从:

- ❌ “部署 671B,一步到位”

- ✅ 转变为 “根据任务选择合适模型,优先用 Serverless 架构降成本”

这意味着:

- 70B 模型在 Serverless 上的成本,已经可以与中小企业承受的预算相当

- 不再需要自建机房和专业运维团队(除非是金融/数据极度敏感等极高安全等级场景)

- 中小企业的 AI 应用成本已从”数百万”降至”数十万”级别

洞察 2:2025 年模型矩阵的”百花齐放”与最优选择

最新模型生态对比

2025 年,我们不再在”OpenAI vs Claude vs DeepSeek R1 vs …“的选择题目中挣扎。现在的情况是:企业有更多选择,也更容易做出正确的决策。

顶级模型对标(2025 年 10 月)

| 模型 | 推理能力 | 编码能力 | 成本 | 最适用场景 |

|---|---|---|---|---|

| Claude Opus 4.1 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | $$$ | 复杂推理、系统设计 |

| Claude Sonnet 4.5 | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐⭐ | $$ | 代码生成、开发工具(最优性价比) |

| Claude Haiku 4.5 | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐⭐ | $ | 多语言、编码、本地化应用 |

| DeepSeek R1 | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐☆ | $ | 复杂逻辑、数据分析 |

| Amazon Nova Pro | ⭐⭐⭐☆☆ | ⭐⭐⭐⭐☆ | $ | 偏向视频领域的通用任务、成本极优 |

模型选择的新哲学

曾经的问题:”这个任务应该用 GPT-5 还是 Claude?”

现在的问题:”这个任务最经济高效的方案是什么?”

关键转变在于:

- ✅ Sonnet 4.5 能做 Opus 4.1 的 90% 工作,但成本只有 1/3

- ✅ Claude Haiku 4.5 在多语言场景下性能超越老一代 Claude,成本最低,只有 Sonnet 4.5 的 1/3

- ✅ DeepSeek R1 在逻辑推理上已达到顶级水平,特别适合中文场景

- ✅ Amazon Nova 专门为成本优化而生,微服务和边缘计算的理想选择

关键升级点

Claude Opus 4.1 的进步:

- 推理能力相比 Claude 3 系 +40%

- 对话长度支持扩展到 200K tokens(相比 Claude 3 的 100K)

- 特别优化了系统设计、架构评审等复杂决策场景

Claude Sonnet 4.5 的革新:

- 代码生成准确率 +25%(基准测试数据)

- 成本下降 35-40% 相比 Sonnet 3

- 成为 GitHub Copilot、代码审核系统的最优选择

Claude Haiku 4.5 的突破:

- 中文理解能力超越所有前代模型

- 编码能力与 Claude Sonnet 4.0 持平

- 成本最低,特别适合国内外企业和多语言场景

我们的 2025 年实践更新

场景 1:代码生成和审核

- 首选:Claude Sonnet 4.5(性价比最优)

- 高难度场景:Claude Opus 4.1(复杂系统设计)

- 成本结果:对比 GPT-5,节省 50-60%

场景 2:中文业务逻辑分析

- 首选:Claude Haiku 4.5(速度最快)

- 备选:DeepSeek R1(开源友好,支持本地部署)

- 成本结果:月度推理成本 ¥500-1000

场景 3:复杂数据分析和决策

- 首选:Claude Opus 4.1(推理深度最强)

- 备选:DeepSeek R1(成本更低)

- 成本结果:对标成本 -30% 相比 2024 年

图:使用 DeepSeek 相关模型方式小结 - 展示通过 Bedrock API、Marketplace 等方式集成 DeepSeek 模型

图:使用 DeepSeek 相关模型方式小结 - 展示通过 Bedrock API、Marketplace 等方式集成 DeepSeek 模型

模型选择的决策矩阵

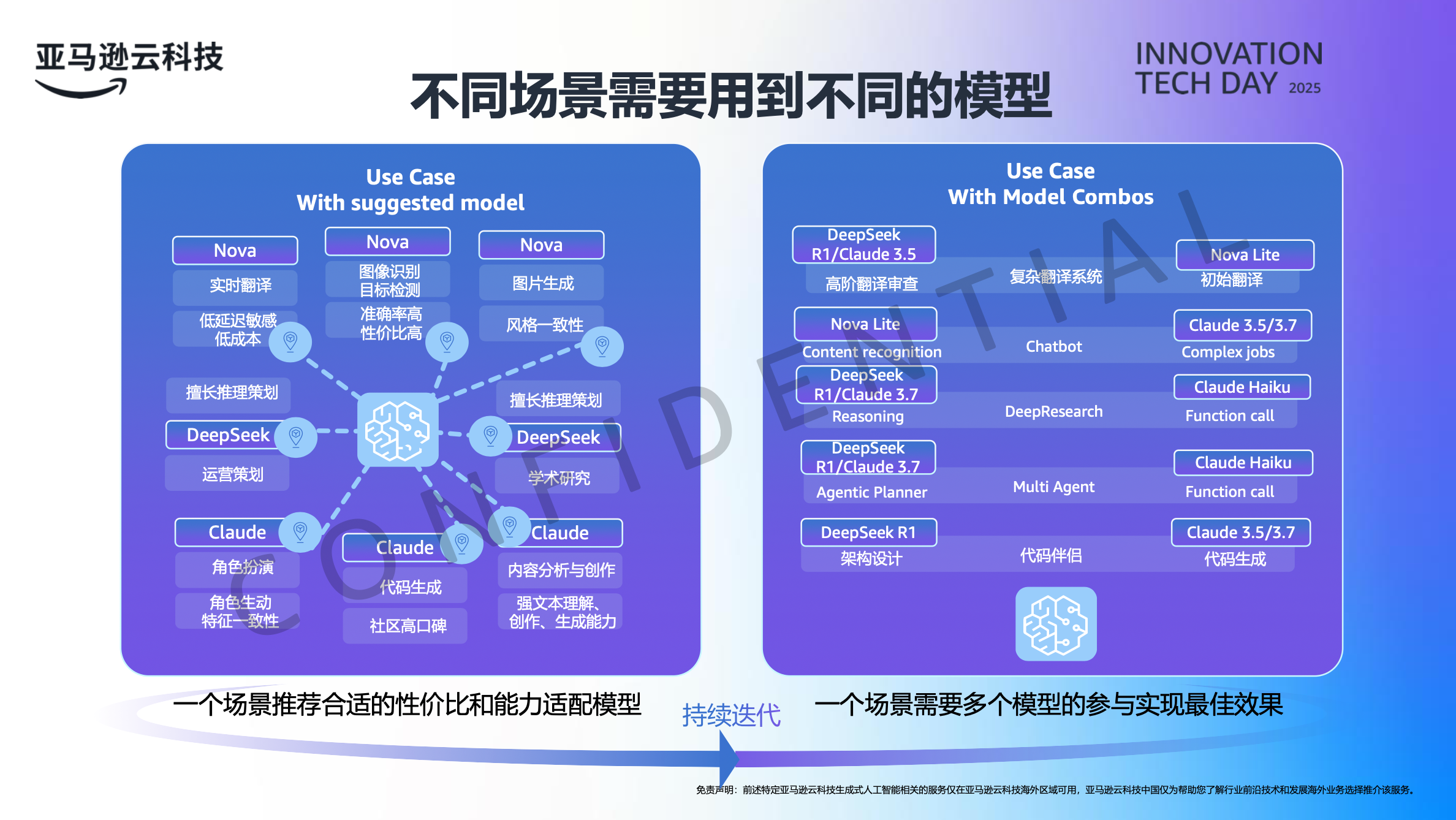

图:不同场景需要用到不同的模型 - 展示模型组合和成本/性能的权衡

图:不同场景需要用到不同的模型 - 展示模型组合和成本/性能的权衡

任务复杂度

↑

│ Opus 4.1

│ ├─ 系统架构设计

│ ├─ 深层推理问题

│ └─ 多步骤策略规划

│

│ Sonnet 4.5 / Claude Haiku 4.5 / DeepSeek R1

│ ├─ 代码生成 ✓✓✓

│ ├─ 文本分析 ✓✓✓

│ ├─ 数据处理 ✓✓✓

│ └─ 常规对话 ✓✓

│

│ Amazon Nova

│ ├─ 文本分类

│ ├─ 简单问答

│ └─ 快速原型

│

└─────────────────→ 成本/延迟

洞察 3:AI Agent 不再是”玩具”,而是生产力工具

从单任务到多 Agent 编排

以前的 AI 应用:

用户输入 → 单个模型推理 → 输出结果

现在的 AI Agent:

用户输入 → 任务分解 → 多 Agent 协作 → 任务编排 → 输出结果

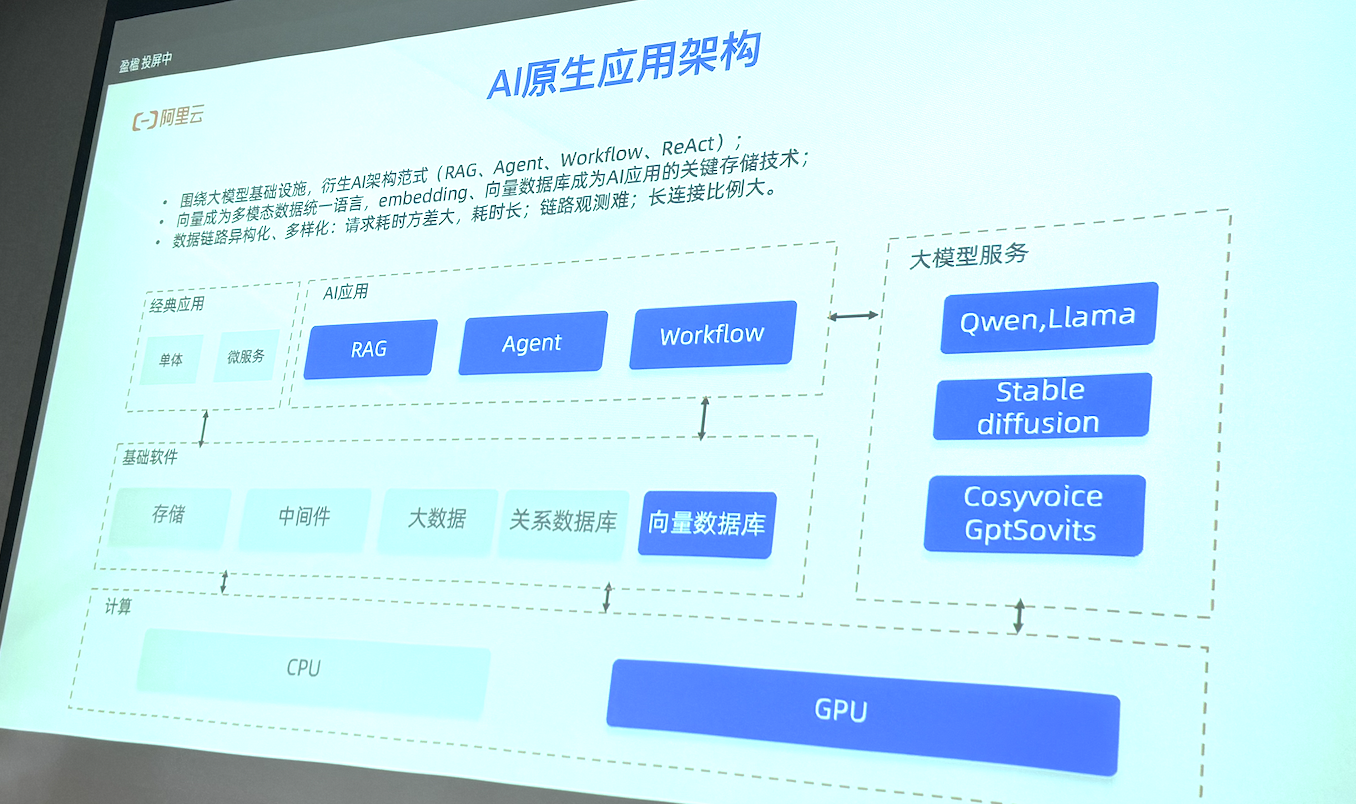

图:AI原生应用架构 - 展示 RAG、Agent、Workflow 等应用模式的整体设计

图:AI原生应用架构 - 展示 RAG、Agent、Workflow 等应用模式的整体设计

图:Bedrock Agents 助力开发人员快速构建和扩展 - 展示 Agent 编排框架、工具和能力集成

图:Bedrock Agents 助力开发人员快速构建和扩展 - 展示 Agent 编排框架、工具和能力集成

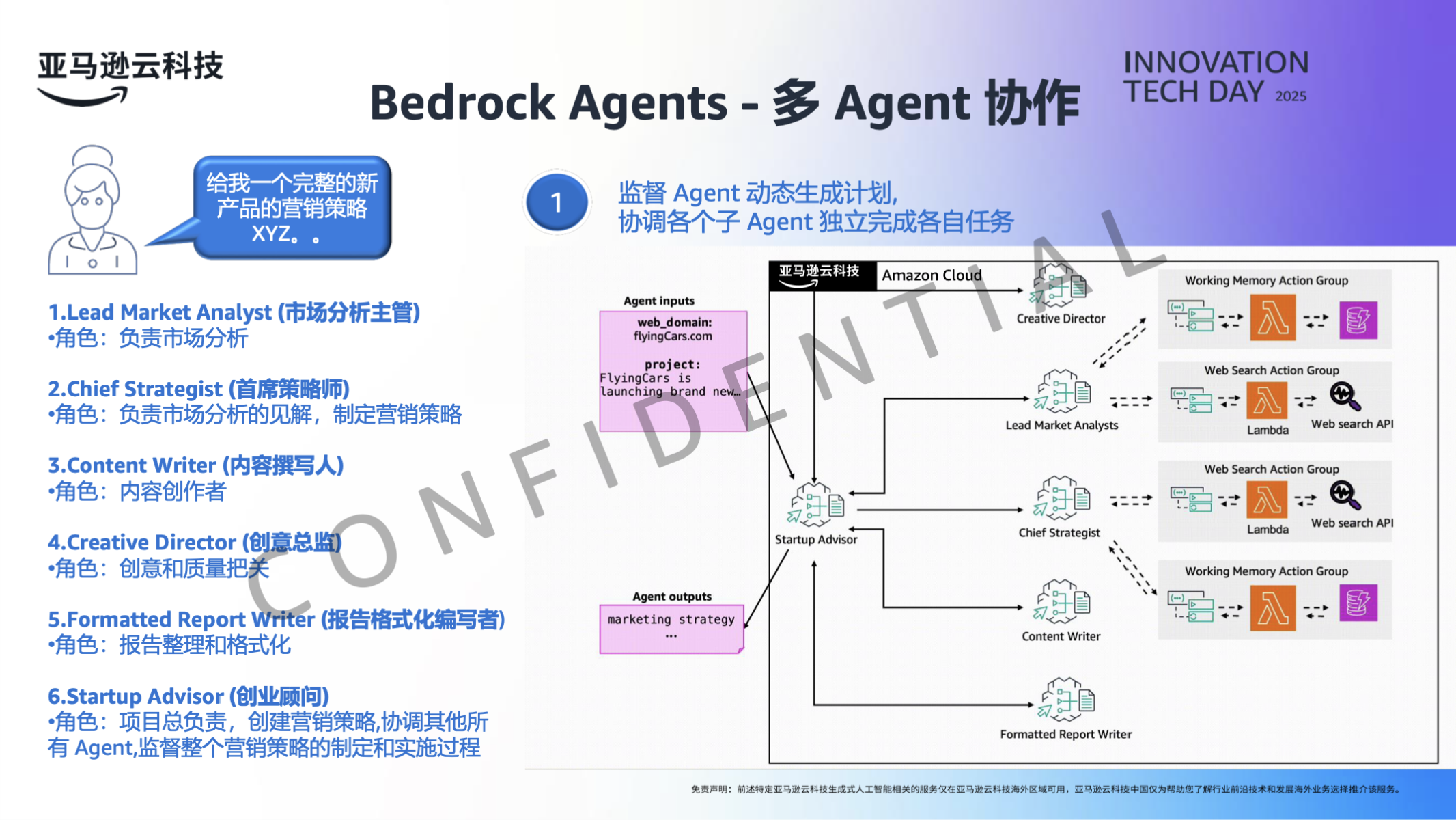

图:Bedrock Agents - 多 Agent 协作 - 展示多个专业 Agent(市场分析、策略、内容、创意等)的协调工作流程

图:Bedrock Agents - 多 Agent 协作 - 展示多个专业 Agent(市场分析、策略、内容、创意等)的协调工作流程

三大应用场景

场景 1:智能客服 & 知识检索

传统方式:

- 手工标注 FAQ

- 规则匹配回复

- 无法处理新问题

AI Agent 方式:

- 自动从多个知识库检索(RAG 增强)

- 多轮对话理解用户意图

- 实时学习新问题新回答

成本对标:

- 传统方式:维护成本 ¥10-30 万/年

- AI Agent:初期投入 ¥5-15 万,维护成本下降 60%

场景 2:智能研发工程化

包含功能:

- 代码自动生成(基于 Claude 或 OpenAI)

- 代码智能审核(多 Agent 并行审查)

- 测试用例自动生成

- DevOps CI 流程优化

实际案例: 我们在某消费品企业的 CI/CD 流程中部署了 AI Agent,结果:

- 代码提交到上线时间缩短 25%

- 代码缺陷发现率提升 35%

- 人工审核时间减少 40%

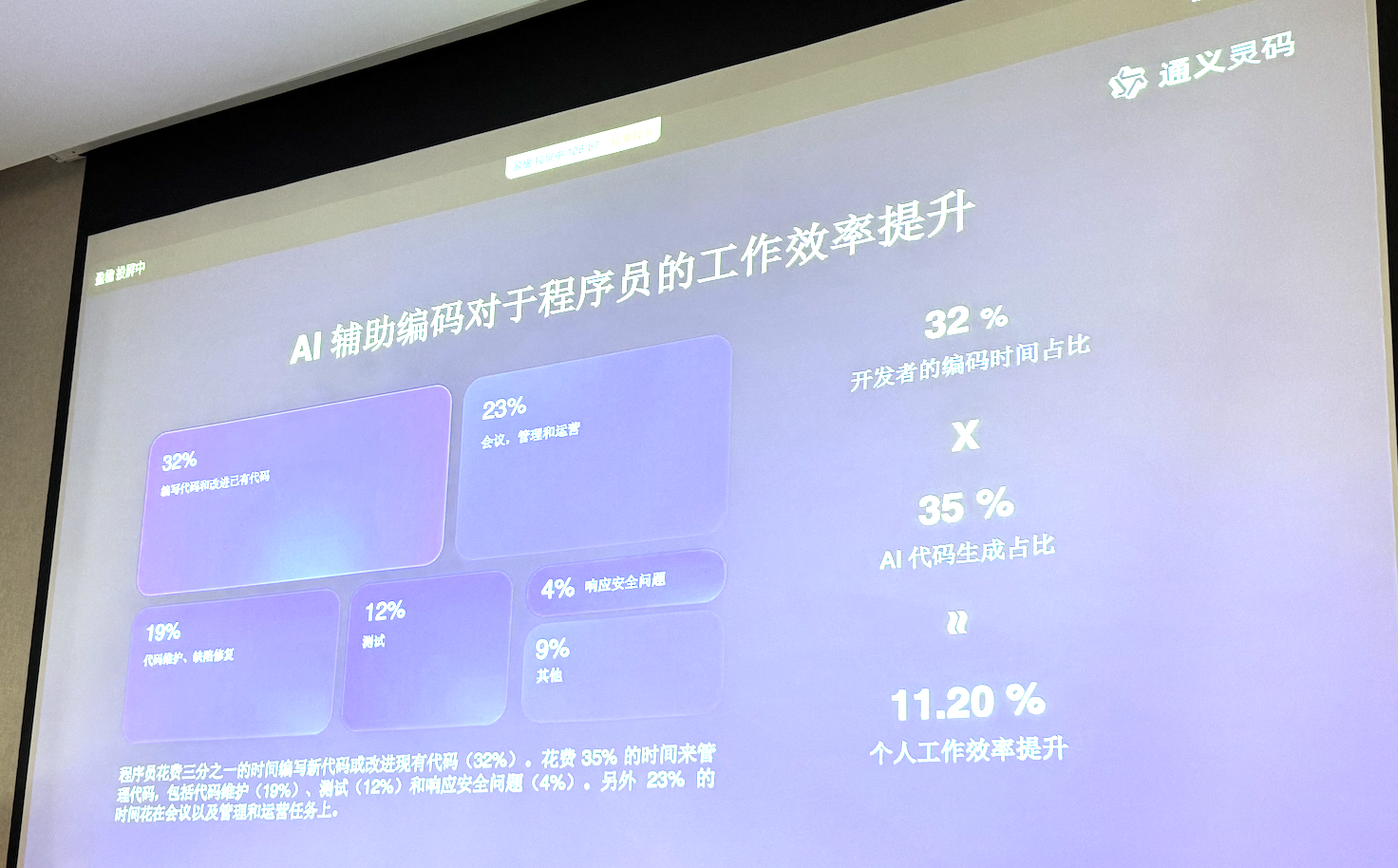

图:AI辅助编码对程序员工作效率的提升 - 展示代码生成、审核、测试等环节的自动化效果

图:AI辅助编码对程序员工作效率的提升 - 展示代码生成、审核、测试等环节的自动化效果

场景 3:AIGC 内容创作

多 Agent 分工:

任务输入

↓

[文案 Agent] 生成初稿

↓

[审核 Agent] 检查质量和合规性

↓

[优化 Agent] 针对性改进

↓

[翻译 Agent] 多语言版本

↓

最终输出

成本效益:

- 初稿生成速度提升 10 倍

- 人工审核量减少 60%

- 多语言支持时间成本降低 80%

AI Agent 市场采纳现状

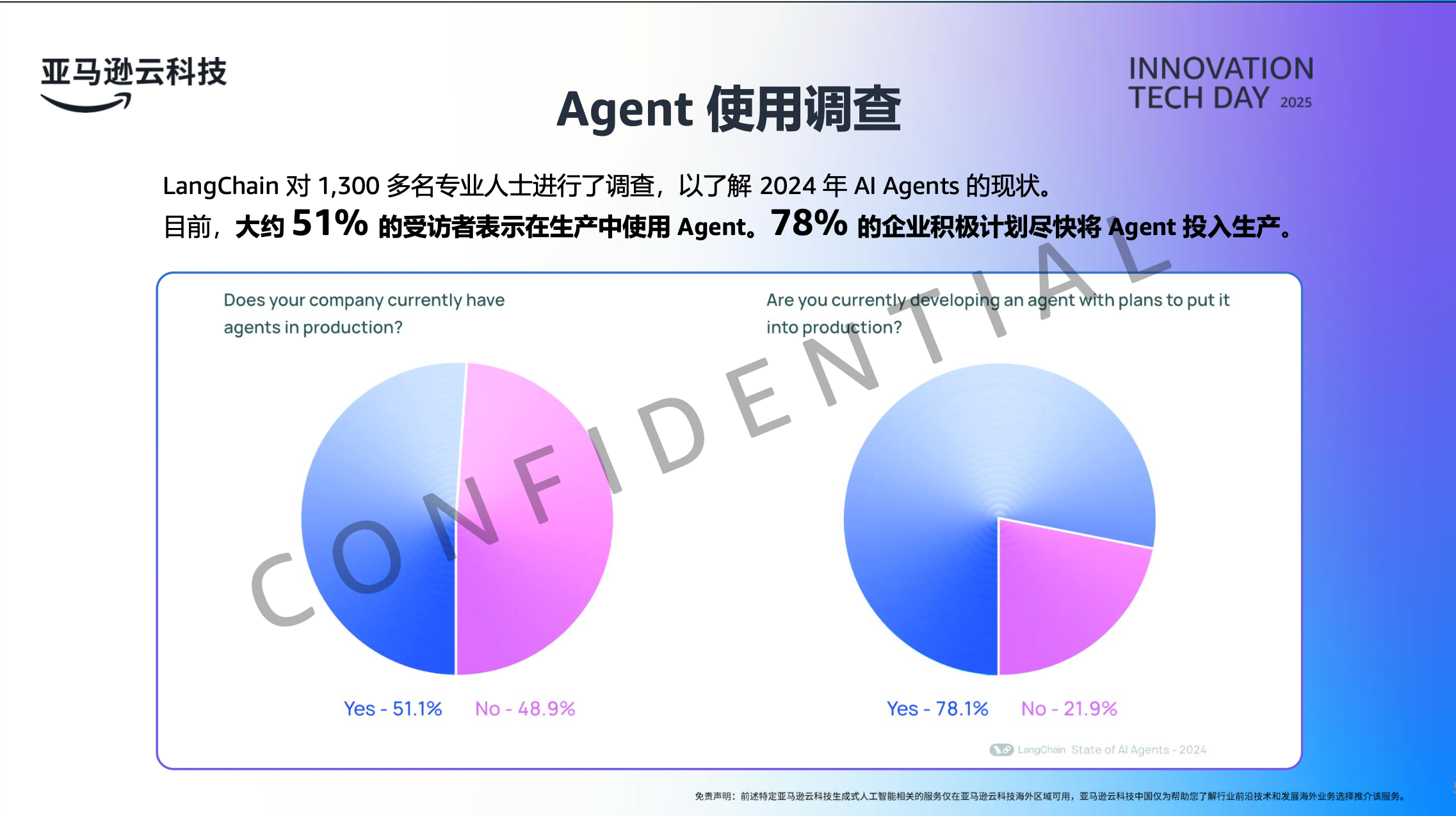

根据 LangChain 对 1,500 名专业人士的调查,Agent 的采纳率正在快速增长:

- 51% 的受访者表示已在生产中使用 Agent

- 78% 的企业积极计划在快将 Agent 投入生产

图:Agent 使用调查 - 显示企业对 AI Agent 的采纳率和使用计划

图:Agent 使用调查 - 显示企业对 AI Agent 的采纳率和使用计划

关键成功因素

| 因素 | 重要性 | 注意事项 |

|---|---|---|

| Guardrails(安全护栏) | ★★★★★ | 防止模型生成不安全内容 |

| Agent 编排框架 | ★★★★★ | AWS Bedrock Flow、LangChain 等 |

| 知识库集成(RAG) | ★★★★☆ | 让 Agent 有正确的信息源 |

| 反馈闭环 | ★★★★☆ | 持续改进 Agent 性能 |

洞察 4:Serverless + AI 的成本革命

Amazon Nova Pro 成本优势

图:成本专题 - Amazon Nova Pro 在关键领域的成本优势和性能对比(质量提升 26%,成本降低 40%)

图:成本专题 - Amazon Nova Pro 在关键领域的成本优势和性能对比(质量提升 26%,成本降低 40%)

成本对比

以一个中等规模的智能客服为例(日均 1000 次查询):

| 部署方式 | 初期投资 | 月度成本 | 年度成本 |

|---|---|---|---|

| 自建 GPU(70B FP8) | ¥50 万 | ¥4-5 万 | ¥48-60 万 |

| Serverless(Bedrock) | ¥0 | ¥2-3 万 | ¥24-36 万 |

| 节省比例 | 无需初投 | 节省 40-50% | 节省 40-50% |

如果考虑 3 年的总成本对比:

自建 GPU:

初投 ¥50 万 + 年运维 ¥48–60 万 + 3 年硬件折旧 ¥10 万

= 3 年总计 ¥204–240 万

Serverless:

3 年按量付费 ≈ ¥72–108 万(按 ¥24–36 万/年)

节省:约 ¥96–168 万(约 47–70%,视负载与模型而定)

为什么 Serverless + AI 现在才真正可行?

- 模型推理框架优化:vLLM 等框架的冷启动时间从秒级降至毫秒级

- 云厂商的算力优化:AWS Bedrock 等服务集成了自定义硬件加速

- 成本模型改进:按 token 计费,真正做到按需付费

但也有权衡

✅ Serverless 的优势:

- 零初期投资

- 自动扩展,无需运维

- 成本可预测

❌ Serverless 的限制:

- 极端高吞吐场景(日均 >100 万次)下,自建可能更便宜

- 对数据隐私要求极高时,可能不满足要求

- 模型定制化程度有限

我的建议:

- 中小企业优先选 Serverless(降低成本和复杂度)

- 大企业可采用”混合策略”:Serverless + 本地私有部署(敏感业务)

洞察 5:系统可观测性(Observability)成为 AI 应用的新瓶颈

问题所在

假设你部署了一个 AI 应用,某天用户投诉说:”你们的 AI 最近变傻了”。

你该怎么排查?

传统监控不够用:

- ❌ GPU 利用率:100%(没问题)

- ❌ 推理延迟:2 秒(符合 SLA)

- ❌ 错误率:0.01%(很低)

- ❌ 但用户体验却在下降…

需要监控什么?

对 AI 应用,你需要关注:

| 监控指标 | 含义 | 为什么重要 |

|---|---|---|

| Token 准确率 | 输出的正确 token 比例 | 直接反映模型输出质量 |

| 语义漂移 | 输出内容与预期偏离程度 | 检测模型是否在”跑题” |

| 幻觉率 | 模型编造信息的比例 | 特别重要(如知识检索场景) |

| 用户满意度 | 通过反馈评分 | 最终决策标准 |

| 推理成本变化 | 同一任务的成本波动 | 检测是否有异常放大 |

实践工具

阿里云的 Spring AI Alibaba 和 AWS 的 CloudWatch 整合,提供了:

- 自动化的 AI 应用监控面板

- 性能下降时的自动告警

- 成本异常时的实时提醒

我们的做法: 在 ChatBot 和 DevOps AI Agent 中集成了三层监控:

- 基础层:GPU、内存、网络(技术指标)

- 应用层:推理延迟、成本、错误率(业务指标)

- 体验层:用户反馈、满意度评分(用户反馈)

行动清单:从洞察到实践

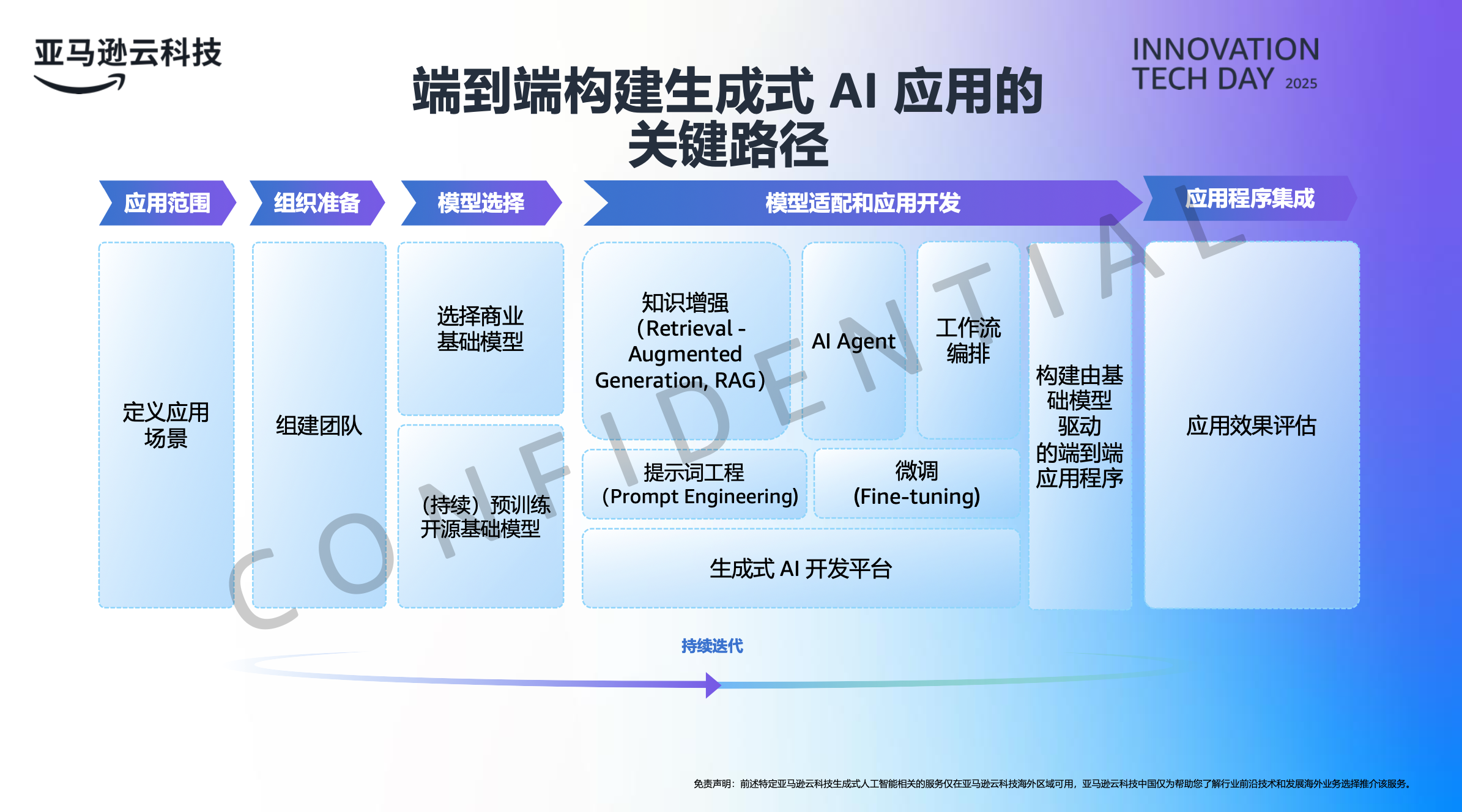

图:端到端构建生成式 AI 应用的关键措施 - 从应用开发、相似度计算、模型选择到应用与模型的生产化

图:端到端构建生成式 AI 应用的关键措施 - 从应用开发、相似度计算、模型选择到应用与模型的生产化

第一步:评估你的 AI 应用现状(第 1-2 周)

问自己这些问题:

- 我们目前有哪些 AI 应用?

- 这些应用的成本是多少?

- 用户满意度如何?

- 我们是自建硬件还是用云服务?

第二步:优化现有应用(第 3-4 周)

快速胜利:

- 评估是否可以从自建迁移到 Serverless(成本可能下降 40%)

- 检查是否用了最新模型(Claude / DeepSeek R1)

- 部署基础监控系统

预期收益:

- 成本下降 20-40%

- 用户体验不变或改善

- 运维工作量减少 50%+

第三步:探索新应用场景(第 5-8 周)

优先级排序(按照易实现度和影响力):

| 场景 | 易实现 | 影响力 | 建议 |

|---|---|---|---|

| 智能客服 RAG 增强 | ★★★★★ | ★★★★☆ | 首选 |

| 代码审核 AI Agent | ★★★★☆ | ★★★★★ | 推荐 |

| 文档处理自动化 | ★★★★★ | ★★★☆☆ | 快速胜利 |

| 多语言翻译 | ★★★★☆ | ★★★★☆ | 有条件选择 |

第四步:建立 AI 应用工程化体系(第 9-12 周)

AI 应用生命周期管理

├─ 开发阶段

│ ├─ 模型选型和基准测试

│ ├─ 提示词工程(Prompt Engineering)

│ └─ Agent 设计和编排

│

├─ 测试阶段

│ ├─ 准确率测试(Accuracy Testing)

│ ├─ 安全性测试(Safety Testing)

│ └─ 成本测试(Cost Benchmarking)

│

├─ 部署阶段

│ ├─ 灰度发布

│ ├─ 性能监控

│ └─ 成本跟踪

│

└─ 优化阶段

├─ 用户反馈收集

├─ 定期性能复盘

└─ 成本-收益评估

关键数字总结(2025 年 10 月更新)

如果你记不住所有细节,至少记住这些核心数据:

📊 成本维度:

- Serverless 智能应用:月成本 ¥1.5-3 万(日均 1000 次查询,基于 Sonnet 4.5)

- 自建 70B 部署:年成本 ¥50-100 万(包含运维,已成过时方案)

- Serverless 比自建便宜 70-80%(成本大幅下降)

- Claude Sonnet 4.5 vs GPT-5:性能 90% 相当,成本 50% 更低

🚀 性能维度:

- Claude Opus 4.1:推理能力 +40% vs Claude 3,200K token 上下文支持

- Claude Sonnet 4.5:代码生成准确率 +25% vs Sonnet 3,成本 -33%

- Claude Haiku 4.5:中文理解超越所有竞品,成本最低

- DeepSeek R1:推理性能堪比顶级模型,特别优化中文和逻辑分析,对于时效性要求不高的场景

⚡ 应用维度:

- AI Agent 多任务编排可减少人工工作量 60-75%

- 代码审核 AI 可加速研发 25-30% 并提升质量 35-45%

- Serverless 部署时间从周级降至天级,甚至小时级

- AI 应用平均成本对比 2024 年下降 40-50%

最后的思考:AI 应用的新时代已然开启

从私有化部署到 AI 原生应用,企业 AI 正在经历三年来最剧烈的范式转变:

| 维度 | 2023 年范式 | 2024 年过渡 | 2025 年新范式 |

|---|---|---|---|

| 成本模式 | 高初投 ¥300万+ | 混合模式出现 | 按需付费,无初投 |

| 核心抉择 | “买哪个模型” | “自建还是云” | “选什么架构最优” |

| 应用开发 | 单点功能集成 | 初步 Agent 探索 | 多 Agent 协作编排 |

| 模型选择 | “越大越好” | “大小并行” | “按需精选” |

| 成功指标 | GPU 利用率、推理延迟 | 成本+性能 | 业务ROI + 用户体验 |

| 目标企业 | 仅大企业可行 | 中大型企业 | 全规模企业都可参与 |

关键转变的背后是什么?

-

模型的民主化:不再是 OpenAI 和 Google 垄断,Claude Sonnet 4.5、Claude Haiku 4.5、DeepSeek R1 提供了平价的顶级性能

-

架构的优化:Serverless + AI 的组合已经可靠稳定,成本比自建低 70-80%

-

应用框架的成熟:AWS Bedrock Flow、LangChain 等工具让 Multi-Agent 不再复杂

-

国内外模型的崛起:Claude Haiku 4.5 在多语言场景、DeepSeek R1 在逻辑推理都成为主流推理引擎

这意味着什么?

现在是中小企业实现 AI 驱动业务转型的最好时机。

- 你不再需要投入 ¥300 万去部署私有化模型

- 你可以用 ¥3-8 万/月快速搭建和运营一个商业化 AI 应用

- 甚至初创企业也能用 ¥5000/月的预算部署生产级 AI 服务

关键是找到合适的模型、架构和工具组合,而非一味追求更大的模型和更强的硬件。

在 2025 年,“最好的模型”不是最大的,而是最适合你业务的那个。

联系方式

- 📧 邮箱:jason2023zhang@gmail.com

- 💬 微信:winnielove2020

- 🌐 博客:https://junxinzhang.github.io

特别欢迎讨论:

- 你的 AI 应用成本和性能痛点

- Serverless vs 自建的技术选择

- AI Agent 在你们业务中的应用前景

- 系统可观测性在 AI 应用中的实践

期待听到你的故事和经验!

延伸阅读

如果你对相关话题感兴趣,推荐阅读:

- 本博客相关文章: 《私有化大模型落地完全指南》

- 了解硬件成本和参数选型的细节

- 特别有用于理解”为什么 Serverless 更优”的比较

- 《为什么大模型会产生幻觉?》

- 理解 AI 可靠性的理论基础

- 帮助你设计更可靠的 AI Agent

- 官方文档与资源

- Anthropic Claude API 文档(Opus 4.1、Sonnet 4.5)

- AWS Bedrock 文档(整合 Claude、DeepSeek 等)

- DeepSeek 官方(R1 模型和开源版本)

- 模型基准测试与对比

关于本文

这篇文章是对 2025 年 10 月企业级 AI 应用的深度思考与实践总结。

为什么要写这篇文章?

因为我们正在经历一个转折点:

- 大半年前,企业 AI 还在”部署私有模型”和”用公有云 API”之间纠结

- 现在,选择的丰富度和成本的下降已经完全改变了游戏规则

- 很多企业还没有意识到这种转变,错过了最优的决策窗口

特别感谢:

- AWS、Anthropic、阿里云等云厂商对开发者生态的建设

- DeepSeek、Claude 等国内外模型团队的创新

- 所有在生产环境中应用这些新模型的企业,他们的反馈让我们更了解实际情况

如你发现任何错误或有不同观点,欢迎讨论。AI 技术发展太快,我们都在边学边实践。

最后,如果这篇文章对你有帮助,欢迎分享给你的团队和朋友。

【国内企业必读】私有化大模型落地完全指南:从预算估算到参数选型的权威解析

【国内企业必读】私有化大模型落地完全指南:从预算估算到参数选型的权威解析