您是否曾经遇到过以下情况?

- 大语言模型(如 ChatGPT、Claude 等)生成了看起来合理但完全错误的信息,我们称之为”幻觉”现象?

- 即使进行了监督微调和人类反馈强化学习(RLHF),模型依然会产生事实上不准确的内容?

- 想要深入理解这种现象背后的根本原因,而不是仅仅停留在表面观察?

如果您对以上任何一个问题感同身受,那么这篇基于最新学术研究的文章就是为您准备的。

近期,Adam Tauman Kalai 等顶级研究者发表了一篇突破性论文《Why Language Models Hallucinate》,从信息论和理论计算机科学的角度,深刻揭示了语言模型幻觉的根本成因。今天,我将与大家分享这项研究的核心洞见,帮助您理解为什么幻觉是当前 AI 技术框架下的”必然之恶”,以及这对 AI 系统设计和应用的深刻启示。

一、核心发现:幻觉为什么不可避免?

这篇论文的最重要贡献在于从理论层面证明了:语言模型的幻觉并非简单的 bug,而是当前训练方法学中内在的、不可完全消除的矛盾。

幻觉的双重来源

1. 预训练阶段的信息丢失

- 语言模型在预训练时,只能基于有限的训练语料库学习知识

- 这意味着某些真实信息会被「压缩」或「遗忘」,而模型会学习填补这些空白

- 即使训练数据质量很高,信息论证明了完全准确的知识编码是不可能的

2. 微调阶段的「能力与准确性」权衡

- 即使通过 RLHF 或 DPO 等先进微调技术,模型仍然面临两难:

- 要么保留广泛的能力,但无法完全修正预训练时的错误

- 要么专注准确性,但会丧失模型的通用能力和创意生成能力

- 这种权衡不是技术限制,而是数学上的必然

理论核心:信息论证明

论文通过以下理论框架证明幻觉不可避免:

- 信息容量有限性:神经网络的参数数量有限,无法存储无限的准确知识

- 学习-准确性权衡:为了获得广泛的任务适应性,模型必然会在某些事实上产生错误

- 优化困局:标准的梯度下降优化无法同时最大化两个相互冲突的目标

二、学术洞见:如何看待幻觉问题?

为什么以前的方法没有解决这个问题?

传统的改进思路主要包括:

| 方法 | 局限性 |

|---|---|

| 增加训练数据 | 数据本身有偏差和不完整性,无法从根本上解决信息丢失问题 |

| 模型扩展 | 虽然更大的模型能存储更多知识,但参数增长速度远低于知识增长速度 |

| 微调与对齐 | 只能在某些分布内改进准确性,对分布外查询仍然无能为力 |

| 检索增强(RAG) | 治标不治本,只是在推理时补充外部知识,但模型本身的幻觉倾向未改变 |

这项研究的启示

- 幻觉是系统性问题,而非偶然现象 - 不应期望通过简单的工程优化完全消除

- 需要新的设计范式 - 或许应该设计模型能够「认知到自己的不确定性」,而非强行生成答案

- 应用场景需要匹配能力 - 在准确性关键的领域(医学、法律、金融),应该采用混合方案(人机协作、外部验证等)

三、实践启示:您应该如何应对?

对于 AI 应用开发者和决策者,这项研究有以下现实建议:

短期应对策略

- 用模型的”置信度”约束 - 在 API 层面限制模型仅在高置信度下给出答案

- 实施多模型投票机制 - 通过多个模型的一致性来提高可信度

- 集成检索和验证 - 对关键信息进行实时验证和出处标注

中期优化方向

- 开发垂直领域的专用模型 - 小而精的模型往往比大模型在特定领域的幻觉更少

- 建立可验证的知识图谱 - 将模型决策与可追踪的知识库绑定

- 制定明确的能力边界 - 告知用户模型的已知限制和不适用场景

长期研究方向

- 探索新的架构设计 - 分离「知识存储」和「推理能力」,而不是混合训练

- 发展形式化验证方法 - 对关键应用进行数学证明而非概率推理

- 重新审视训练目标 - 考虑加入「知识不确定性建模」作为优化目标之一

四、相关资源与深度阅读

原论文:Why Language Models Hallucinate

- arXiv ID: 2509.04664

- 作者:Adam Tauman Kalai, Ofir Nachum, Santosh S. Vempala, Edwin Zhang

- 发表时间:2025年9月

核心概念解读:

- 什么是信息论中的”容量-准确性权衡”?

- 为什么 RLHF 无法完全解决幻觉问题?

- 形式化验证在 AI 中的角色

相关研究方向:

- 不确定性量化(Uncertainty Quantification)在 LLM 中的应用

- 可解释性研究对幻觉问题的启示

- 神经符号方法(Neuro-Symbolic AI)作为可能的解决方案

五、总结

这项研究的价值在于将幻觉问题从”我们还不知道如何修复的 bug”重新定位为”我们需要重新思考 AI 架构的根本问题”。

关键要点:

✓ 幻觉不是可以被完全消除的问题,而是当前 LLM 设计的固有属性 ✓ 理解这一点对构建可靠的 AI 系统至关重要 ✓ 未来的 AI 应该更加”诚实”地表达自己的不确定性,而非无限生成 ✓ 在高风险应用中,必须采用人机协作和外部验证机制

六、联系与讨论

如果您对大语言模型、AI 安全、或相关的深度技术话题感兴趣,欢迎与我交流:

- 您是否在实际项目中遇到过 LLM 幻觉问题?

- 对将这类研究应用到生产环境有什么想法?

- 期待听到您的经验和见解!

📧 邮箱:jason2023zhang@gmail.com 💬 微信:winnielove2020 🌐 技术博客:https://junxinzhang.github.io

这篇文章是对学术研究的深度解读和实践应用指导。如有学术引用需求,请参考原论文。

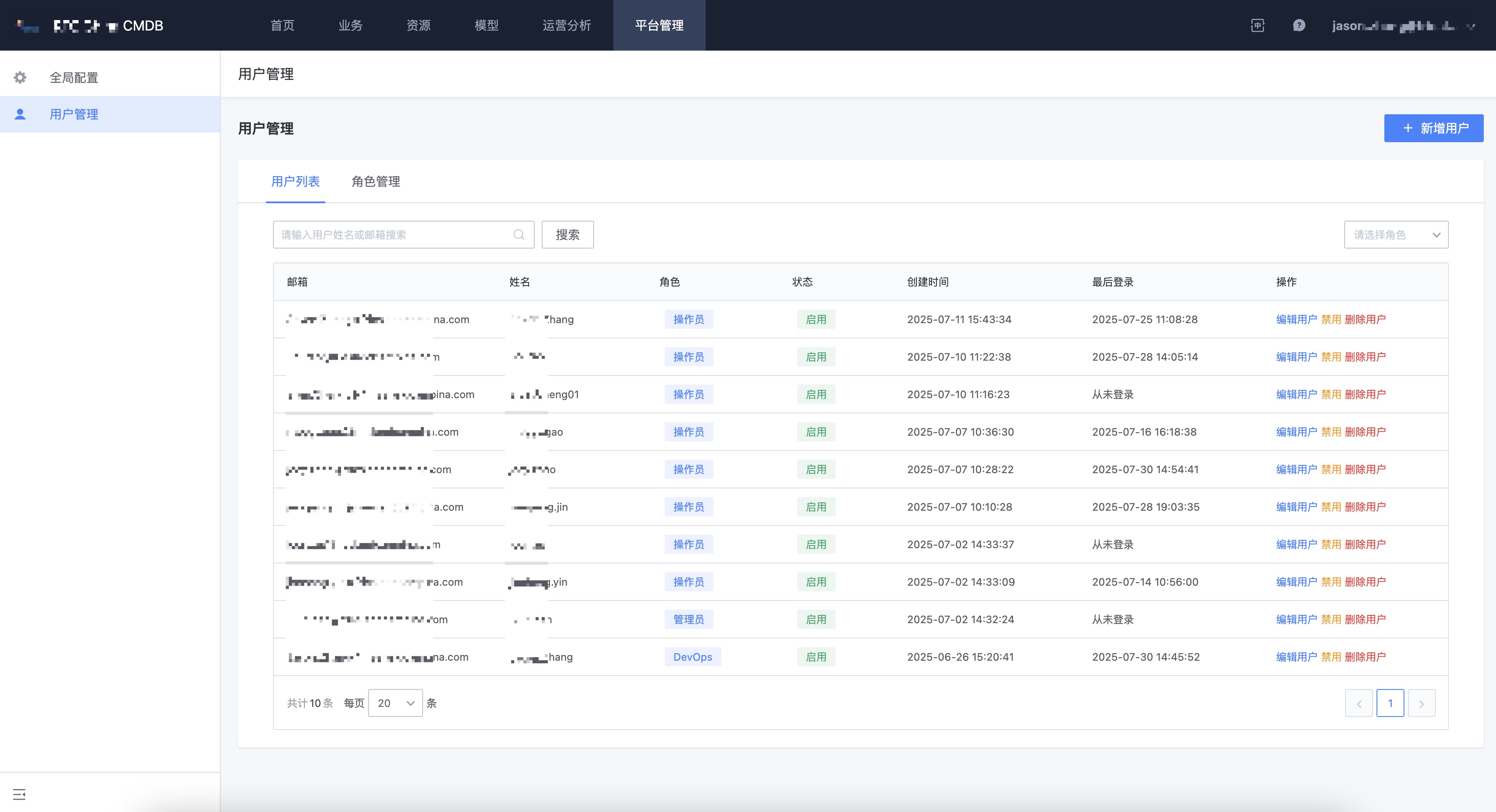

【蓝鲸CMDB深度定制】还在为权限管理烦恼?看我如何从0到1打造一套精细化用户管理系统!

【蓝鲸CMDB深度定制】还在为权限管理烦恼?看我如何从0到1打造一套精细化用户管理系统!